por Arthur William Cardoso Santos | jun 22, 2023 | Inteligência Artificial, Saúde

As ferramentas de Inteligência Artificial, em especial as generativas, têm o potencial de provocar uma nova revolução industrial e sua rápida adoção exige um esforço para garantir que o impacto da IA na sociedade seja regulado com participação social e transparência. A preocupação reside no fato de ainda serem desconhecidos os impactos da IA na sociedade, por isso iniciativas como a carta do instituto Future of Life dialogam com o “Princípio da precaução”, muito comum na área ambiental, medida que assegura a sustentabilidade do planeta.

Além da desinformação, o desemprego estrutural é uma ameaça a trabalhadores cujos ofícios têm potencial para serem automatizados pela Inteligência Artificial. A carta do instituto Future of Life elenca algumas destas demanda para o enfrentamento desse cenário:

Sistemas poderosos de IA devem ser desenvolvidos apenas quando estivermos confiantes de que seus efeitos serão positivos e seus riscos serão administráveis. Essa confiança deve ser bem justificada e aumentar com a magnitude dos efeitos potenciais de um sistema.

[…] os desenvolvedores de IA devem trabalhar com os formuladores de políticas para acelerar drasticamente o desenvolvimento de sistemas robustos de governança de IA. Estes devem incluir, no mínimo: autoridades reguladoras novas e capazes dedicadas à IA; supervisão e rastreamento de sistemas de IA altamente capazes e grandes conjuntos de capacidade computacional; sistemas de proveniência e marca d’água para ajudar a distinguir o real do sintético e rastrear vazamentos de modelos; um ecossistema robusto de auditoria e certificação; responsabilidade por danos causados pela IA; financiamento público robusto para pesquisa técnica de segurança de IA; e instituições com bons recursos para lidar com as dramáticas perturbações econômicas e políticas (especialmente para a democracia) que a IA causará (FUTURE OF LIVE, 2023, tradução nossa).

Algumas das sugestões já estão em processo de incorporação pelas ferramentas dentro do estabelecimento de boas práticas para a IA Generativa, tais quais a citação das fontes utilizadas e o treinamento de IA apenas utilizando como base material previamente autorizado.

Estas ações por parte das próprias empresas dialogam com o “Dever de Cuidado”, situação em que as ferramentas se responsabilizam pelas consequências do mau uso das mesmas. Este pensamento fez com que gigantes como Google e Facebook não lançassem como produto, até então, as ferramentas de inteligência artificial que desenvolviam em seus laboratórios.

A popularização do ChatGPT, entretanto, causou uma corrida desenfreada pelo desenvolvimento de novas aplicações de IA, fato que coloca um ponto de atenção sobre as questões éticas envolvidas, principalmente a partir da demissão em massa das equipes responsáveis por esta análise em alguns das principais Big Techs (CRIDDLE, 2023).

A autorização de uso de aplicações de IA na área médica já foi normatizada no Brasil pela Anvisa, mas para o caso das IAs Generativas focadas para o público em geral, a certificação de ferramentas que utilizam repositórios confiáveis seria fundamental a fim de evitar desinformação. Já existem selos como o HONcode e o “Selo Sergio Arouca de Qualidade da Informação em Saúde na Internet”. Quanto aos repositórios, podemos citar o ARCA para artigos científicos e o PCDaS para dados estruturados.

Assim como os curadores da Wikipédia ajudam a prevenir que a plataforma reproduza preconceitos, informações equivocadas de colaboradores mal intencionados e propaganda disfarçada de conteúdo informativo, é preciso estabelecer mecanismo de aprendizagem por reforço a partir de feedbacks (RLHF) por parte de estudiosos no tema.

Para além da marca d’água sugerida pelo instituto Future of Life, outra ação importante seria no sentido de obrigar as ferramentas a incluir um identificador nos metadados de fotos e vídeos gerados por IA, assim como já acontece nas câmeras fotográficas que registram no arquivo informações como modelo da câmera, abertura de íris, lente utilizada, entre outros dados. Em sentido similar, o rastreamento digital dos conteúdos gerados via IA poderia ser verificado por meio da Blockchain, em funcionamento similar à geração de NFTs. Se tal medida infringir os ditames da LGPD, a verificação pode ser apenas booleana, retornando somente dois valores: 1 – Produzido por IA; 2 – Não produzido por IA.. Este sistema de verificação funcionaria como um plataforma de Fact checking, evitando assim a desinformação a partir da disseminação de mídia sintética ou deepfake.

Também fundamental é a transparência sobre o funcionamento da IA, condição chamada de “explicabilidade” ou “interpretabilidade”. Adicionalmente, as respostas de IA deveriam exibir as métricas para avaliação de sua confiabilidade, como acurácia e precisão.

Ainda na mesma linha, a adoção de padrões abertos permitiria a interoperabilidade das informações que devem ser entendidas como um bem público, sejam elas de Open Health ou Open Science.

Por último, o papel da regulação legal/infralegal, garantindo que os direitos fundamentais do cidadão sejam assegurados como o Direito à Saúde e o Direito à Comunicação, tão caros numa sociedade desigual como a brasileira.

O Projeto de Lei 21/2020 objetiva criar um Marco Legal da Inteligência Artificial. O texto inicial previa a criação de um “relatório de impacto”, além da responsabilização legal dos agentes de IA, sejam eles desenvolvedores como também as empresas que implementam as aplicações. Mesmo sendo aprovado pela Câmara dos Deputados em 2021, não seguiu adiante e já é considerado obsoleto.

Por este motivo, um grupo de juristas formou uma comissão para construir um anteprojeto em 2022 que fosse atemporal e não se tornasse obsoleto com a evolução tecnológica. Além do PL 21/2020, o anteprojeto visa substituir outros projetos de lei (PL 5.051/2019 e PL 872/2021) que tratam do mesmo tema. A proposta é que, com a regulamentação, as ferramentas possam “obedecer a princípios como liberdade de escolha, transparência, rastreabilidade de decisões, responsabilização, reparação de danos, inclusão e não-discriminação” (FRAGOSO, 2022), assegurando a explicabilidade e a privacidade de que tratamos ao longo deste artigo.

Esta última proposta foi apresentada oficialmente pelo presidente do Senado Federal, Rodrigo Pacheco, na forma do Projeto de Lei n° 2338/2023.

Ainda estamos no início da adoção da IA pela sociedade em geral e esperamos que os princípios e diretrizes do SUS pautem o uso da Inteligência Artificial na Saúde, promovendo universalização, equidade, integralidade, regionalização, hierarquização, descentralização e participação social, além de associar sua implementação no SUS ao desenvolvimento tecnológico pelo Complexo Econômico-Industrial da Saúde (CEIS) como um dos principais pilares da Quarta Revolução Tecnológica.

RERERÊNCIAS:

ANVISA. RESOLUÇÃO DE DIRETORIA COLEGIADA – RDC No 657, DE 24 DE MARÇO DE 2022 – RESOLUÇÃO DE DIRETORIA COLEGIADA – RDC No 657, DE 24 DE MARÇO DE 2022 – DOU – Imprensa Nacional. Disponível em: https://www.in.gov.br/en/web/dou/-/resolucao-de-diretoria-colegiada-rdc-n-657-de-24-de-marco-de-2022-389603457. Acesso em: 25 abr. 2023.

BRASIL. Senado Federal. Projeto de Lei nº 2.338, de 3 de maio de 2023. Dispõe sobre o uso da Inteligência Artificial. Brasília: Senado Federal, 2013. Disponível em: https://www25.senado.leg.br/web/atividade/materias/-/materia/157233. Acesso em: 9 mai. 2023.

CRIDDLE, C.R. Big techs geram preocupação ao demitir equipes que cuidavam de ética em IA. Folha de S. Paulo, 29 mar. 2023. Disponível em: https://www1.folha.uol.com.br/tec/2023/03/big-techs-geram-preocupacao-ao-demitir-equipes-que-cuidavam-de-etica-em-ia.shtml. Acesso em: 25 abr. 2023.

Ep.129 – O que é Chat GPT e qual seu uso na saúde?. [Locução de:] Fernanda Velloni, Felipe Kitamura, Giancarlo Domingues. [S. l.]: DASA EDUCA, 23 fev. 2023. Podcast. Disponível em: https://www.youtube.com/watch?v=CfWTbzK3V-s. Acesso em: 25 abr. 2023.

FRAGOSO, R. Comissão de juristas aprova anteprojeto do marco legal da inteligência artificial. Rádio Senado, 1 dez. 2022. Disponível em: https://www12.senado.leg.br/noticias/audios/2022/12/comissao-de-juristas-aprova-anteprojeto-do-marco-legal-da-inteligencia-artificial. Acesso em: 25 abr. 2023.

FUTURE OF LIFE. Pause Giant AI Experiments: An Open Letter – Future of Life Institute. Disponível em: https://futureoflife.org/open-letter/pause-giant-ai-experiments/. Acesso em: 23 abr. 2023.

GADELHA, C. A. G.; TEMPORÃO, J. G. Desenvolvimento, inovação e saúde: a perspectiva teórica e política do Complexo Econômico-Industrial da Saúde. Ciência & Saúde Coletiva, Rio de Janeiro, v. 23, n. 6, p.1891-1902, 2018. DOI: https://doi.org/10.1590/1413-81232018236.06482018.

GADELHA, C. A. G. O Complexo Econômico-Industrial da Saúde 4.0: por uma visão integrada do desenvolvimento econômico, social e ambiental. Cadernos do Desenvolvimento, Rio de Janeiro, v. 16, n. 28, p. 25-49, 2021. Disponível em: http://www.cadernosdodesenvolvimento.org.br/ojs-2.4.8/index.php/cdes/article/view/550. Acesso em: 25 abr. 2023.

GADELHA, C. A. G. (org.). Saúde é Desenvolvimento: o Complexo Econômico-Industrial da Saúde como opção estratégica nacional. Rio de Janeiro: Fiocruz – CEE, 2022.

GOLDIM, J. R. Princípio da Precaução. Disponível em: https://www.ufrgs.br/bioetica/precau.htm. Acesso em: 25 abr. 2023.

LIMA, J. DA C. Desafios para a adoção de Inteligência Artificial pelo Sistema Único de Saúde (SUS): ética, transparência e interpretabilidade. Tese (Doutorado em Informação e Comunicação em Saúde) – Instituto de Comunicação e Informação Científica e Tecnológica em Saúde, Fundação Oswaldo Cruz, Rio de Janeiro, 2022.

SANTOS, A. W. C.. Inteligência Artificial Generativa, dados pessoais e Literacia Digital em Saúde: possibilidades, desigualdades e limites. Disponível em: https://arthurwilliam.com.br/wp-content/uploads/2023/05/Inteligencia-Artificial-Generativa-dados-pessoais-e-Literacia-Digital-em-Saude-Arthur-William-Cardoso-Santos.pdf. Acesso em: 31 mai. 2023.

WIGGERS, K. With Firefly, Adobe gets into the generative AI game. TechCrunch, 21 mar. 2023. Disponível em: https://techcrunch.com/2023/03/21/adobe-firefly-generative-ai/. Acesso em: 25 abr. 2023.

por Arthur William Cardoso Santos | jun 21, 2023 | Inteligência Artificial, Saúde

A Literacia em Saúde (Health Literacy) tem ação fundamental no papel ativo do cidadão no âmbito da Saúde, deixando de ser entendido como um mero coadjuvante dentro de uma postura passiva em relação aos profissionais, mas sim dando segurança a seu protagonismo e coparticipação nos processos envolvidos.

A literacia em saúde pode ser definida como um amplo e diverso conjunto de habilidades e competências que os indivíduos utilizam para buscar, compreender, avaliar e dar sentido a informações sobre saúde, visando ao cuidado de sua própria saúde ou de terceiros. Essa ampla gama de habilidades (PERES et al., 2021).

Já a Literacia Digital em Saúde (eHealth literacy – eHL) consiste na articulação de seis domínios distintos: literacia tradicional e numérica; literacia Digital; Literacia midiática; literacia em informação; Literacia Científica; e Literacia em Saúde.

O conjunto completo de habilidades relacionadas à eHL, portanto, compreenderia competências relacionadas não apenas à saúde, mas também à alfabetização tradicional (ou básica), conceitos numéricos, computadores, mídia, ciência e informação. Possuir todas essas habilidades integradas da eHL permitiria aos usuários obter resultados positivos não apenas no comportamento relacionado à busca de informações, mas também uma maior probabilidade de se envolver em experiências proativas relacionadas à saúde (SOUZA, 2020).

Antes passivos, aguardando a ação dos profissionais da Saúde, os pacientes informados ou pacientes digitais estão engajados na busca ativa por informações em Saúde disponíveis na internet. Estas informações podem vir da busca do Google (fenômeno conhecido popularmente como Dr. Google), das redes sociais e de mensagens do WhatsApp.

A construção da RNDS e a implementação do Open Health no Brasil facilita o acesso do cidadão a seus dados de Saúde, antes restritos a laboratórios, consultórios e hospitais. A partir do empoderamento do paciente com o domínio de suas informações, o SUS caminharia para a construção de uma “tecnodemocracia”.

A proposta de uma tecnodemocracia, que tenha por objeto de seu exercício a definição de uma PMIS, representa uma tentativa de dar materialidade à idéia da apropriação pela sociedade de um aparato até então quase que de uso restrito pelos dispositivos de vigilância, de controle de gestão da vida, cuja chave de acesso é de domínio reservado de uma elite científica e técnica, política e econômica (MORAES, 1998).

Este empoderamento do paciente cria uma relação mais horizontal com o médico, tendo o profissional de Saúde vindo a desempenhar mais um papel de tutor na atenção primária com a coparticipação do paciente.

A prática de Telessaúde sofreu grande impulso devido à pandemia de Covid-19 e foi autorizada por meio da Lei nº 13.989, de 15 de abril de 2020. Posteriormente, a Lei nº 14.510, de 27 de dezembro de 2022, veio a regulamentar definitivamente a prática da Telessaúde no Brasil alterando a Lei do SUS (Lei nº 8.080 de 1990).

As ferramentas de IA Generativa também ajudam a intensificar a relação entre médico e paciente durante as consultas. Ao ter automatizado o preenchimento do prontuário, o profissional da Saúde pode privilegiar a conversa com o paciente, na medida em que os dados serão estruturados no banco de dados pela IA a partir do processamento em tempo real do áudio da conversa no consultório.

Como a perspectiva de que a IA não seja autônoma, ao final da conversa, o médico revisaria as informações sistematizadas pela ferramenta, corrigindo, se necessário, algum equívoco no entendimento antes da finalização da consulta.

A partir do carregamento de dados pessoais históricos de Saúde, a IA já poderia indicar em tempo real perguntas para o médico fazer ao paciente. No caso de esquecer de alguma informação protocolar, o sistema sinalizaria o fato ao profissional.

Por conta da confidencialidade das informações do paciente, é fundamental que os sistemas de NLP que vão acompanhar a conversa durante a consulta forneçam garantias seguras de que o áudio não será gravado, armazenado ou utilizado para outros fins senão aqueles autorizados.

A adoção da IA Generativa nos consultórios não será mandatória, porém com a melhoria na comunicação daqueles que optarem por seu uso, esta será uma reivindicação natural dos pacientes, assim como os recursos de agendamento online, receita digital e teleconsulta. O nível de literacia tende a ser um dos fatores de escolha do profissional de Saúde, na medida em que é baixo quando o paciente nem ao menos consegue entender o nome do medicamento e a posologia indicada na prescrição médica por conta da letra escrita no papel em dinâmicas de atendimento não digitalizadas.

REFERÊNCIAS:

BRASIL. Lei nº 14.510, de 27 de dezembro de 2022. Altera a Lei nº 8.080, de 19 de setembro de 1990, para autorizar e disciplinar a prática da telessaúde em todo o território nacional, e a Lei nº 13.146, de 6 de julho de 2015; e revoga a Lei nº 13.989, de 15 de abril de 2020. Diário Oficial da União, Brasília, DF, 2022. Disponível em: http://www.planalto.gov.br/ccivil_03/_ato2019-2022/2022/lei/L14510.htm. Acesso em: 25 abr. 2023.

MORAES, I. H. S. DE. Informações em saúde: para andarilhos e argonautas de uma tecnodemocracia emancipadora. 1998. 285 f. Tese (Doutorado em Saúde Pública) – Escola Nacional de Saúde Pública Sergio Arouca, Fundação Oswaldo Cruz, Rio de Janeiro, 1998.

PERES, F. A LITERACIA EM SAÚDE NO CHATGPT: EXPLORANDO O POTENCIAL DE USO DE INTELIGÊNCIA ARTIFICIAL PARA A ELABORAÇÃO DE TEXTOS ACADÊMICOS. SciELO Preprints, 2023. DOI: 10.1590/SciELOPreprints.5658. Disponível em: https://preprints.scielo.org/index.php/scielo/preprint/view/5658. Acesso em: 18 maio. 2023.

SANTOS, A. W. C.. Inteligência Artificial Generativa, dados pessoais e Literacia Digital em Saúde: possibilidades, desigualdades e limites. Disponível em: https://arthurwilliam.com.br/wp-content/uploads/2023/05/Inteligencia-Artificial-Generativa-dados-pessoais-e-Literacia-Digital-em-Saude-Arthur-William-Cardoso-Santos.pdf. Acesso em: 31 mai. 2023.

SOUZA, N. F. M. L. DE. eHealth literacy entre jovens: estudo exploratório sobre o papel das condições socioeconômicas no uso da informação sobre saúde na Internet. 2020. 195 f. Dissertação (Mestrado em Informação e Comunicação em Saúde) – Instituto de Comunicação e Informação Científica e Tecnológica em Saúde, Fundação Oswaldo Cruz, Rio de Janeiro, 2020.

por Arthur William Cardoso Santos | jun 20, 2023 | Inteligência Artificial, Saúde

O ChatGPT atingiu bons resultados no USMLE (United States Medical Licensing Examination), prova obrigatória para o exercício da profissão médica nos Estados Unidos (KUNG et al., 2023). Isto quer dizer que ele é suficientemente capaz de substituir um médico? A resposta é “não” e vamos explicar o porquê.

Primeiramente, por hora, as ferramentas de IA tendem a gerar bons resultados quando focadas em apenas uma tarefa e tendo como base uma grande quantidade de exemplos pré-treinados. No entanto, a Inteligência Artificial não é tão eficiente quando precisa executar uma tarefa complexa a partir de poucos dados.

A IA Generativa é calcada no machine learning, processo em que as máquinas aprendem sem serem programadas. Há métodos de aprendizagem supervisionados, não supervisionados e por reforço, porém ainda são ferramentas em processo de aprendizado, sendo que suas respostas devem sempre ser validadas posteriormente. Analogamente, seria como esperar respostas científicas definitivas de um estudante universitário na iniciação científica. Mesmo com acesso a livros da biblioteca e de repositórios online, sua capacidade cognitiva para a pesquisa científica ainda está em formação, podendo ser amadurecida em etapas posteriores como mestrado, doutorado e pós-doutorado.

O GPT utiliza o aprendizado profundo (deep learning) a partir da arquitetura Transformer, porém lança mão de algumas técnicas que explicam o aparecimento de respostas equivocadas ou a pura “alucinação” (Hallucination).

Por se tratar de um bate-papo, o ChatGPT precisa dar respostas rápidas. “A pressa é inimiga da perfeição” é um famoso ditado popular que ajuda a entender as consequências do uso das técnicas de Zero-shot, One-shot e Few-shot a partir do GPT-2. Ao se deparar com perguntas para as quais não tem nenhuma referência (Zero-Shot), apenas uma referência (One-shot) ou poucas referências (Few-shot), a ferramenta tenta prever uma resposta correta. É como se fôssemos perguntar para crianças sobre assuntos que desconhecem. Vão dar uma resposta, mas com elevado potencial de equívoco.

Este processo é muito natural em aplicações de inteligência artificial quando operadas por cientistas de dados em processos de treinamento por reinforcement learning e supervised learning. Por outro lado, estas questões não estão visíveis para o público leigo que muitas vezes entende a IA Generativa como uma espécie de oráculo.

Os sistemas de Inteligência Artificial possuem métricas para avaliar a tolerância de confiabilidade: acurácia, precisão, interpretabilidade e F1 score. A transparência destas métricas é fundamental para verificar a validade das informações.

Na mesma linha, a revista Nature proibiu que o ChatGPT seja creditado como autor de artigos científicos. Isto porque um dos princípios de autoria de artigos científicos é a responsabilidade pelo teor do texto e isto o ChatGPT não pode fazer.

O ChatGPT é uma ferramenta generalista e a tendência é a criação de aplicativos de LLM especializados em segmentos como o da Saúde. Neste caso, os profissionais devem entender a ferramenta não como uma solução pronta, mas sim como um projeto em constante construção e evolução (mentalidade do software livre). Requer, portanto, uma ação humana no sentido de detectar erros, propor melhorias, acompanhar a performance e avaliar os resultados.

REFERÊNCIAS:

KUNG, T. H. et al. Performance of ChatGPT on USMLE: Potential for AI-assisted medical education using large language models. PLOS Digital Health, v. 2, n. 2, p. e0000198, 9 fev. 2023.

NATURE. Tools such as ChatGPT threaten transparent science; here are our ground rules for their use. Nature, v. 613, n. 7945, p. 612–612, 24 jan. 2023.

SANTOS, A. W. C.. Inteligência Artificial Generativa, dados pessoais e Literacia Digital em Saúde: possibilidades, desigualdades e limites. Disponível em: https://arthurwilliam.com.br/wp-content/uploads/2023/05/Inteligencia-Artificial-Generativa-dados-pessoais-e-Literacia-Digital-em-Saude-Arthur-William-Cardoso-Santos.pdf. Acesso em: 31 mai. 2023.

THORP, H. H. ChatGPT is fun, but not an author | Science. Disponível em: https://www.science.org/doi/10.1126/science.adg7879. Acesso em: 23 abr. 2023.

por Arthur William Cardoso Santos | jun 19, 2023 | Inteligência Artificial, Saúde

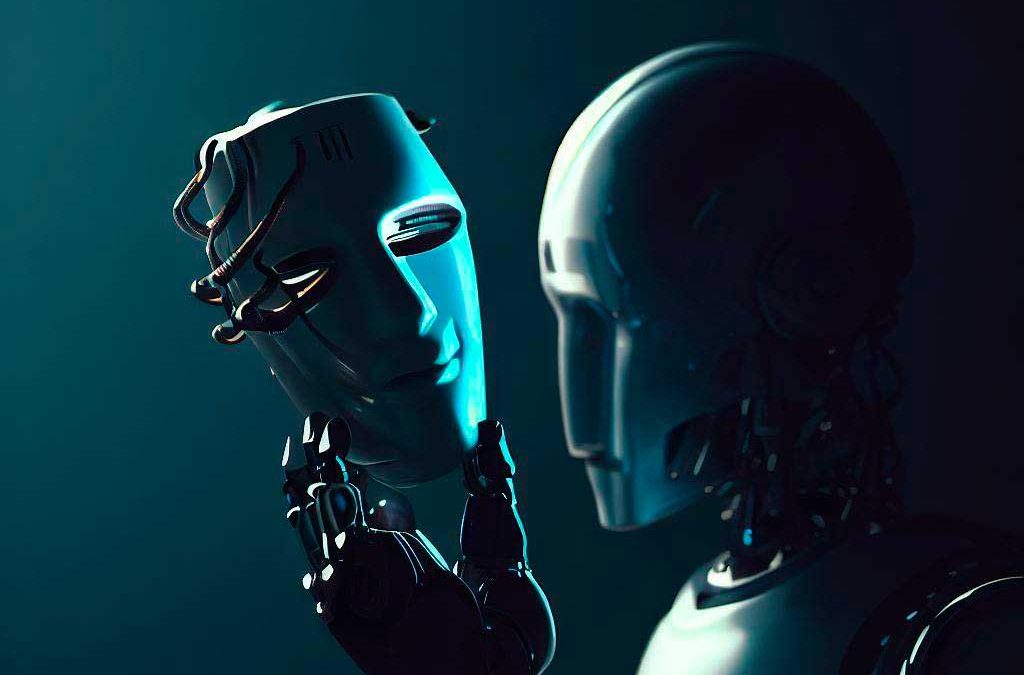

A euforia inicial com a IA Generativa levou à crença de que estas ferramentas substituiriam os seres humanos, numa espécie de “piloto automático”, contudo uma dinâmica que tem ganhado força leva a crer que a IA se portará mais como um “copiloto”. Este conceito ajuda a entender a relação entre humanos e máquinas, na medida em que os copilotos atuam no auxílio do comandante. Esta delegação de tarefas ao “copiloto” não retira o protagonista do piloto, mas permite que ele se engaje nas atividades mais importantes.

A existência de um copiloto em um avião aumenta a segurança em momentos críticos, a detecção de problemas e a indicação de possíveis caminhos para sua resolução. O copiloto é um auxiliar do comandante. Todas as suas sugestões são avaliadas e decididas pelo piloto.

Deste modo, as projeções de ficção científica em que os profissionais seriam substituídos por avatares sintéticos automatizados não é válida por hora. Na área da Saúde, a IA Generativa possibilitaria que o médico gaste mais tempo na comunicação com o paciente e menos tempo preenchendo prontuários e relatórios graças à capacidade da máquina em analisar o conteúdo da conversa através de técnicas como speech analytics e text mining.

As ferramentas de IA Generativa, portanto, ajudariam no preenchimento automático de prontuários e outros documentos. Grosso modo, seria como se estivesse pedindo para um residente esboçar um relatório que seria revisado posteriormente pelo médico.

A capacidade de síntese da IA Generativa também pode reduzir as falhas de comunicação durante um “handoff” ou um “handover” de pacientes, momento em que há transferência de médico, de turno, de hospital ou de unidade (UTI, quarto, etc), garantindo um elevado nível de informação entre todas as equipes que acompanham a jornada do paciente.

O paciente pode ainda ter seus exames explicados por meio de linguagem personalizada, proporcionando uma facilitação na literacia em Saúde.

A própria Educação já está se adaptando à chegada da IA Generativa. Ao invés de proibir o uso do ChatGPT em trabalhos escolares, alguns professores propõem que os alunos gerem textos pela plataforma e revisem as respostas dadas pelo robô a fim de encontrar erros nos textos produzidos por IA.

O livro “The AI Revolution in Medicine GPT-4 and Beyondm”, de Peter Lee, Carey Goldberg e Isaac Kohane, traz uma cena hipotética de um residente sendo orientado pelo GPT-4 durante uma situação de emergência.

Ainda é muito cedo para prever todas as possibilidades de uso da IA Generativa na Saúde, mas numa área tão sensível, é preciso estar atento aos limites desta tecnologia.

REFERÊNCIAS:

LEE, P; GOLDBERG, C; KOHANE, I. The AI Revolution in Medicine: GPT-4 and Beyond. Pearson Education; 2023.

SANTOS, A. W. C.. Inteligência Artificial Generativa, dados pessoais e Literacia Digital em Saúde: possibilidades, desigualdades e limites. Disponível em: https://arthurwilliam.com.br/wp-content/uploads/2023/05/Inteligencia-Artificial-Generativa-dados-pessoais-e-Literacia-Digital-em-Saude-Arthur-William-Cardoso-Santos.pdf. Acesso em: 31 mai. 2023.

por Arthur William Cardoso Santos | jun 16, 2023 | Inteligência Artificial, Saúde

A principal característica da Inteligência Artificial Generativa é gerar textos, fotos e vídeos. Estas produções das ferramentas de IA são conhecidas como “mídia sintética”. Popularizada por aplicativos como o “Reface”, as primeiras experiências de Deepfake (troca de rostos e voz em vídeos) assustaram por demonstrar o potencial de sua utilização em ações de desinformação. Contudo o simples compartilhamento de textos não confiáveis gerados por LLM como o ChatGPT já pode promover tal situação.

Como o ChatGPT tem uma capacidade de processamento muito grande, pode produzir textos convincentes sobre diversos temas. O usuário, sem conseguir discernir a veracidade das informações, acaba compartilhando este material e os receptores o entendem como informação confiável.

O cenário acima já está em prática por diversos influenciadores da internet que utilizam o ChatGPT para produzir “dicas” para sua audiência sobre temas que não dominam. Tal situação é mais preocupante quando se trata da área da Saúde.

O canal no YouTube do influenciador Murilo Bevervanso possui quase 250 mil seguidores. No vídeo “Chatgpt cria videos do Youtube pra voce em alguns cliques Aprenda a como ganhar dinheiro No Youtube” (https://youtu.be/zYsLmKtIyG8), Murilo ensina a produção de dicas de emagrecimento com informações de nutrição, exercícios físicos e pressão arterial com base em consulta ao ChatGPT. Não há nas respostas do ChatGPT nenhuma indicação de fonte e nem confirmação de que as informações foram atestadas por profissionais de Nutrição e Educação Física.

No vídeo acima, o influenciador ainda mostra a como utilizar o texto gerado pelo ChatGPT para alimentar outra ferramenta de IA, a Synthesia, por onde é possível criar um avatar virtual e uma locução sintética para um vídeo que será postado no YouTube com o objetivo de influenciar pessoas.

Já no canal “Ganhando no Automático”, o influenciador Marcos Teixeira sugere o uso do ChatGPT em conjunto com a ferramenta de “Invideo”. No vídeo “Como criar vídeo em segundos com inteligência artificial grátis e zero de experiência” (https://youtu.be/8wrnG4q0jgM), Marcos mostra que o aplicativo “Invideo” processa o texto gerado pelo ChatGPT e monta automaticamente um vídeo-legenda com imagens relacionadas aos temas abordados.

Na mesma linha, o canal “Gus.A.I” perguntou ao ChatGPT quais os melhores assuntos para um canal do youtube e recebeu a indicação de “saúde” entre uma das possibilidades. Também no vídeo “Como criar Videos Youtube com ChatGPT-OpenAI / 100% Automático com Edição de Inteligência Artificial” (https://youtu.be/Vqvc_xBoqkE), o youtuber ensina a usar a ferramenta “Pictory”, um aplicativo de edição de vídeo baseado em IA que monta automaticamente um vídeo-legenda a partir de textos do ChatGPT.

Os três casos acima acendem o sinal amarelo para a criação de mídia sintética em massa a partir da integração de serviços de IA Generativa, principalmente na área da Saúde.

Há iniciativas no sentido de aprimorar a base de dados com a qual a IA Generativa é treinada. O GPT-3, por exemplo, é treinado lançando mão das bases Common Crawl, WebText2, Wikipedia, Books1 e Books2. A proposta alternativa seria limitar este universo apenas a textos acadêmicos, como testado pela ferramenta “Consensus”. Entretanto, parte dos artigos científicos encontra-se em repositórios fechados (situação contrária à Open Science), além disso existe o entendimento de que as publicações científicas apresentam visões sobre temas e não constituem uma verdade universal, sendo assim, mesmo em artigos revisados pelos pares, as conclusões precisam ser interpretadas pelo leitor como uma tese.

No mesmo sentido do Consensus, o investidor estadunidense Elon Musk anunciou o desenvolvimento da ferramenta TruthGPT, que teria como diferencial uma pretensa busca da verdade. Musk foi um dos signatários da carta do instituto Future of Life que pede uma pausa nos experimentos com Inteligência Artificial.

No campo da Saúde, esta preocupação é maior pois a desinformação pode resultar em mortes direta ou indiretamente, como constatado durante a Infodemia no contexto da Covid-19. Como vimos, há no Brasil uma desigualdade no acesso à internet reforçada pelos planos “zero-rating”, contribuindo para que a predominância das informações seja acessada via mídias sociais pelas classes C, D e E. Somada a isto, a descrença com meios de comunicação tradicionais e a popularização dos influencers (influenciadores digitais) cria um ambiente propício para a dinâmica da “apomediação” (SOUZA, 2020) (apomediation), apontada pela pesquisadora Nicole Fajardo Maranha Leão de Souza, ao analisar o comportamento de um grupo de estudantes que optava preferencialmente por informar-se pelas recomendações de outros usuários da internet.

Entre os alunos do colégio de Manguinhos, também parece ser comum a prática da busca de informações sobre saúde no Google ou no Youtube. No questionário, a maior parte indicou o Google como a fonte mais confiável para informações sobre saúde na internet. Outra atitude frequente entre esses jovens, conforme eles relataram no grupo focal, é consultar a avaliação e a opinião de outros usuários da Internet, seja para julgar a confiabilidade de uma fonte de informação ou para orientar-se sobre o uso de determinado recurso ou aplicativo. Na opinião deles, o que estiver bem avaliado por outros usuários, merece confiança (SOUZA, 2020).

Em paralelo à penetração da IA Generativa, é preciso apostar em políticas públicas que promovam a educomunicação, trabalhando o desenvolvimento de habilidades de leitura crítica da mídia. A Finlândia, por exemplo, é considerada como um país sem fake news, pois incluiu no currículo escolar a alfabetização midiática (BENKE; SPRING, 2022).

Mesmo tendo sua popularização apenas recentemente, a IA Generativa já causou alguns casos de desinformação em escala global. Imagens sintéticas do Papa Francisco vestindo um casaco fashion e do ex-presidente Donald Trump sendo detido viralizaram na internet. Muitas pessoas acreditaram nas imagens que já contavam com grande realismo após a atualização da ferramenta Midjourney. A polêmica trouxe novos usuários para o aplicativo que decidiu manter seu funcionamento apenas para assinantes a um preço mínimo de oito dólares mensais.

Mais um ponto de atenção reside na possibilidade de o ChatGPT exibir anúncios em suas respostas. Ainda não está claro como esta funcionalidade será implementada, mas a mesma deve ocorrer com muita precaução para que as respostas orgânicas não sejam confundidas com as publicidades, assim como ocorre na busca do Google, onde há grande destaque aos anúncios e a diferenciação visual é pouco perceptível.

A situação pode ser ainda mais grave se nas respostas houver privilégio à consulta de textos de determinado anunciante, dentro de uma estratégia de Marketing de Conteúdo. A título de comparação, o conflito de interesses seria análogo caso outras ferramentas de IA como Waze e Google Maps alterassem seus resultados para que a rota passasse por algum comércio anunciante. Com a Internet das Coisas (IoT), tal situação ficaria ainda mais crítica, pois o sistema de IA teria acesso a dados como o combustível restante e a agenda (consultando festas e indicando possibilidade de compra de presentes), fazendo com que o motorista pare em determinado shopping ou posto de gasolina a partir da influência do aplicativo.

REFERÊNCIAS:

BENKE, E.; SPRING, M. Como a Finlândia tem conseguido derrotar as “fake news”. BBC News Brasil, 25 out. 2022. Disponível em: https://www.bbc.com/portuguese/internacional-63390825. Acesso em: 25 abr. 2023.

SANTOS, A. W. C.. Inteligência Artificial Generativa, dados pessoais e Literacia Digital em Saúde: possibilidades, desigualdades e limites. Disponível em: https://arthurwilliam.com.br/wp-content/uploads/2023/05/Inteligencia-Artificial-Generativa-dados-pessoais-e-Literacia-Digital-em-Saude-Arthur-William-Cardoso-Santos.pdf. Acesso em: 31 mai. 2023.

SOUZA, N. F. M. L. DE. eHealth literacy entre jovens: estudo exploratório sobre o papel das condições socioeconômicas no uso da informação sobre saúde na Internet. 2020. 195 f. Dissertação (Mestrado em Informação e Comunicação em Saúde) – Instituto de Comunicação e Informação Científica e Tecnológica em Saúde, Fundação Oswaldo Cruz, Rio de Janeiro, 2020.

por Arthur William Cardoso Santos | jun 15, 2023 | Inteligência Artificial, Saúde

A partir daqui, vamos abordar o uso de aplicações de Inteligência Artificial focadas em compreender, processar e gerar linguagem humana. O NLP (“Processamento de Linguagem Natural” na tradução livre) é o ramo da Inteligência Artificial que abarca a interação entre seres humanos e máquinas por meio de linguagem natural. Já a IA Generativa é uma técnica que permite a geração de textos, fotos, vídeos e até música com base em grandes modelos de linguagem (LLM – Large Language Models).

Até recentemente, a NLP estava restrita a chatbots que apresentavam limitações nos processos de compreensão dos comandos humanos (NLU – Natural-language understanding) e na geração de respostas (NLG – Natural-language generation), tais como Alexa, Siri e Google Assistant.

O diferencial das novas ferramentas como o ChatGPT é a utilização de uma arquitetura de aprendizagem profunda (Deep Learning) baseada em “Transformers”, tecnologia desenvolvida pelo Google em 2017. O ChatGPT é nada mais que um chatbot baseado na tecnologia GPT (Generative Pre-trained Transformer). O GPT foi desenvolvido pela OpenAI, uma organização sem fins lucrativos cujo objetivo é popularizar o uso da Inteligência Artificial. O GPT também é o motor do DALL-E, ferramenta de IA que gera imagens sintéticas a partir de comandos de texto.

Para se ter uma ideia, o GPT-3 (lançado em 11 de julho de 2020) possui 175 bilhões de parâmetros de aprendizado de máquina.. Em comparação, o GPT-4, lançado em 14 de março de 2023, conta com 100 trilhões de parâmetros de aprendizado. Além disso, a versão mais recente agregou novas funcionalidades como a capacidade de compreender imagens, processar textos de até 25 mil palavras e possui maior preocupação com vieses e preconceitos. Atualmente, o GPT-4 está disponível apenas para assinantes do plano PLUS ao custo de 20 dólares mensais. O acesso gratuito dá direito apenas a versão 3.5 do GPT.

Na área da ciência de dados, a NLP pode atuar na estruturação de dados não-estruturados, enriquecendo as informações de bancos de dados a serem analisados pela Inteligência Artificial. Já a IA Generativa, ajudaria a romper a “síndrome da página branca”, constituindo-se como um framework para que a produção intelectual não parta do zero.

A IA Generativa impõe uma mudança nas habilidades fundamentais para o mundo profissional, sendo a metacognição uma delas. A capacidade de fazer boas perguntas (prompt) e de interpretar respostas pode vir a ser uma tendência num mundo com forte presença da IA Generativa, promovendo até mesmo o aparecimento de novas profissões com o “Engenheiro de Prompt”.

Embora ainda não se conheçam os limites do potencial do ChatGPT e de outras ferramentas de modelo de linguagem, os primeiros experimentos indicam que será necessário saber interagir com esses sistemas de inteligência artificial (IA) para obter resultados satisfatórios. As novas aptidões moldariam uma profissão do futuro: o engenheiro de prompt. Nessa abordagem, prompt é a linha de comando na qual se digita, em texto corrente, a pergunta que o computador vai responder (STEIW, 2023).

REFERÊNCIAS:

SANTOS, A. W. C.. Inteligência Artificial Generativa, dados pessoais e Literacia Digital em Saúde: possibilidades, desigualdades e limites. Disponível em: https://arthurwilliam.com.br/wp-content/uploads/2023/05/Inteligencia-Artificial-Generativa-dados-pessoais-e-Literacia-Digital-em-Saude-Arthur-William-Cardoso-Santos.pdf. Acesso em: 31 mai. 2023.

STEIW, L. Com o ChatGPT, a engenharia de prompt desponta como uma nova profissão. Insper: Ensino Superior em Negócios, Direito, Engenharias e Ciência da Computação, 7 mar. 2023. Disponível em: https://www.insper.edu.br/noticias/com-o-chatgpt-a-engenharia-de-prompt-desponta-como-uma-nova-profissao/. Acesso em: 25 abr. 2023.