por Arthur William Cardoso Santos | jun 15, 2023 | Inteligência Artificial, Saúde

A partir daqui, vamos abordar o uso de aplicações de Inteligência Artificial focadas em compreender, processar e gerar linguagem humana. O NLP (“Processamento de Linguagem Natural” na tradução livre) é o ramo da Inteligência Artificial que abarca a interação entre seres humanos e máquinas por meio de linguagem natural. Já a IA Generativa é uma técnica que permite a geração de textos, fotos, vídeos e até música com base em grandes modelos de linguagem (LLM – Large Language Models).

Até recentemente, a NLP estava restrita a chatbots que apresentavam limitações nos processos de compreensão dos comandos humanos (NLU – Natural-language understanding) e na geração de respostas (NLG – Natural-language generation), tais como Alexa, Siri e Google Assistant.

O diferencial das novas ferramentas como o ChatGPT é a utilização de uma arquitetura de aprendizagem profunda (Deep Learning) baseada em “Transformers”, tecnologia desenvolvida pelo Google em 2017. O ChatGPT é nada mais que um chatbot baseado na tecnologia GPT (Generative Pre-trained Transformer). O GPT foi desenvolvido pela OpenAI, uma organização sem fins lucrativos cujo objetivo é popularizar o uso da Inteligência Artificial. O GPT também é o motor do DALL-E, ferramenta de IA que gera imagens sintéticas a partir de comandos de texto.

Para se ter uma ideia, o GPT-3 (lançado em 11 de julho de 2020) possui 175 bilhões de parâmetros de aprendizado de máquina.. Em comparação, o GPT-4, lançado em 14 de março de 2023, conta com 100 trilhões de parâmetros de aprendizado. Além disso, a versão mais recente agregou novas funcionalidades como a capacidade de compreender imagens, processar textos de até 25 mil palavras e possui maior preocupação com vieses e preconceitos. Atualmente, o GPT-4 está disponível apenas para assinantes do plano PLUS ao custo de 20 dólares mensais. O acesso gratuito dá direito apenas a versão 3.5 do GPT.

Na área da ciência de dados, a NLP pode atuar na estruturação de dados não-estruturados, enriquecendo as informações de bancos de dados a serem analisados pela Inteligência Artificial. Já a IA Generativa, ajudaria a romper a “síndrome da página branca”, constituindo-se como um framework para que a produção intelectual não parta do zero.

A IA Generativa impõe uma mudança nas habilidades fundamentais para o mundo profissional, sendo a metacognição uma delas. A capacidade de fazer boas perguntas (prompt) e de interpretar respostas pode vir a ser uma tendência num mundo com forte presença da IA Generativa, promovendo até mesmo o aparecimento de novas profissões com o “Engenheiro de Prompt”.

Embora ainda não se conheçam os limites do potencial do ChatGPT e de outras ferramentas de modelo de linguagem, os primeiros experimentos indicam que será necessário saber interagir com esses sistemas de inteligência artificial (IA) para obter resultados satisfatórios. As novas aptidões moldariam uma profissão do futuro: o engenheiro de prompt. Nessa abordagem, prompt é a linha de comando na qual se digita, em texto corrente, a pergunta que o computador vai responder (STEIW, 2023).

REFERÊNCIAS:

SANTOS, A. W. C.. Inteligência Artificial Generativa, dados pessoais e Literacia Digital em Saúde: possibilidades, desigualdades e limites. Disponível em: https://arthurwilliam.com.br/wp-content/uploads/2023/05/Inteligencia-Artificial-Generativa-dados-pessoais-e-Literacia-Digital-em-Saude-Arthur-William-Cardoso-Santos.pdf. Acesso em: 31 mai. 2023.

STEIW, L. Com o ChatGPT, a engenharia de prompt desponta como uma nova profissão. Insper: Ensino Superior em Negócios, Direito, Engenharias e Ciência da Computação, 7 mar. 2023. Disponível em: https://www.insper.edu.br/noticias/com-o-chatgpt-a-engenharia-de-prompt-desponta-como-uma-nova-profissao/. Acesso em: 25 abr. 2023.

por Arthur William Cardoso Santos | jun 14, 2023 | Inteligência Artificial, Saúde

Para assegurar a confiabilidade das informações fornecidas por aplicações de Inteligência Artificial, é fundamental conhecer o funcionamento dos algoritmos, contudo a maioria das ferramentas atua como caixas pretas (black boxes), tornando opacos e nada transparentes os critérios que levaram a máquina a chegar em determinado resultado. Na área financeira, por exemplo, um sistema de IA deve ser desenvolvido de forma a permitir que as avaliações de crédito sejam transparentes e permitam rastreabilidade.

O conceito da “explicabilidade” ou “interpretabilidade” diz respeito à capacidade de compreender os detalhes por trás do funcionamento de determinado algoritmo, explicando seu processo decisório.

Para o campo da saúde, apesar das enormes promessas de aplicações de Machine Learning, é fundamental entender o que motivou uma determinada decisão. Não parece razoável que médicos e pacientes recebam sem questionar diagnósticos que não podem ser explicados. Neste caso, a preocupação e busca por soluções tecnológicas “interpretáveis” são fundamentais não só para dar transparência para médicos e pacientes, mas para todas as partes interessadas, inclusive aos órgãos reguladores (LIMA, 2022).

A Explainable Artificial Intelligence (XAI) está, portanto, ligada à responsabilidade algorítmica e à transparência de processos de aprendizado de máquina (NUNES; MORATO, 2021).

Na versão 4 do GPT, a máquina adquiriu a capacidade de citar as fontes utilizadas para a geração da resposta, mas como está disponível apenas para os assinantes do plano Plus, a maioria dos usuários ainda enfrenta grande dificuldade em explicar as informações geradas pela IA.

Para o SUS, é fundamental que os sistemas de inteligência artificial funcionem dentro de uma mentalidade de software livre, com o compartilhamento não apenas de seus benefícios, mas também de abertura do “código”, medida que propiciaria o aprimoramento das ferramentas, o controle social da IA na Saúde, além do desenvolvimento de aplicações específicas derivadas.

O ideal é que pesquisa e ferramentas que utilizam dados públicos possam compartilhar não apenas gráficos e textos de suas conclusões, mas também o código utilizado para tal, criando um ecossistema de partilha de benefícios entre atores privados e públicos (semicommons), neste caso com startups e healthtechs de um lado e o SUS do outro.

LIMA, J. DA C. Desafios para a adoção de Inteligência Artificial pelo Sistema Único de Saúde (SUS): ética, transparência e interpretabilidade. Tese (Doutorado em Informação e Comunicação em Saúde) – Instituto de Comunicação e Informação Científica e Tecnológica em Saúde, Fundação Oswaldo Cruz, Rio de Janeiro, 2022.

NUNES, D.; MORATO, O. A explicabilidade da inteligência artificial e o devido processo tecnológico. Disponível em: https://www.conjur.com.br/2021-jul-07/opiniao-explicabilidade-ia-devido-processo-tecnologico. Acesso em: 25 abr. 2023.

SANTOS, A. W. C.. Inteligência Artificial Generativa, dados pessoais e Literacia Digital em Saúde: possibilidades, desigualdades e limites. Disponível em: https://arthurwilliam.com.br/wp-content/uploads/2023/05/Inteligencia-Artificial-Generativa-dados-pessoais-e-Literacia-Digital-em-Saude-Arthur-William-Cardoso-Santos.pdf. Acesso em: 31 mai. 2023.

por Arthur William Cardoso Santos | jun 9, 2023 | Inteligência Artificial, Saúde

A coleta de dados é premissa para sistemas de inteligência artificial, contudo é preciso garantir os direitos do cidadão à privacidade e protegê-lo de usos não autorizados de suas informações pessoais.

Nos Estados Unidos, a rede de farmácias CVS está atuando fortemente no uso de dados de Saúde (DARIN, 2021). No Brasil, o Grupo DPSP (dono das drogarias Pacheco e São Paulo) opera no sentido de construir um marketplace médico pautado nos dados de clientes dentro da modalidade de OpenHealth.

O Google também voltou a investir na coleta de dados de saúde dos usuários Android (SOARES, 2021). Já a startup Drumwave trabalha na monetização de dados pessoais de usuários de serviços financeiros e de saúde.

Entretanto, sem a devida regulamentação, o uso destes dados pessoais pode causar medidas prejudiciais ao cidadão em processos como o tempo de carência e o reajuste de planos de saúde com base na probabilidade de uso do serviço (sinistros). Por isso, a Rede Nacional de Dados de Saúde (RNDS) possibilitaria a implementação do Open Health com controle social, um dos pilares do SUS.

Alinhado a isto, a Lei Geral de Proteção de Dados Pessoais (LGPD) impõe limites claros para os tipos de uso permitidos para os de Saúde. A Lei nº 13.709, de 14 de agosto de 2018 estabelece que:

II – dado pessoal sensível: dado pessoal sobre origem racial ou étnica, convicção religiosa, opinião política, filiação a sindicato ou a organização de caráter religioso, filosófico ou político, dado referente à saúde ou à vida sexual, dado genético ou biométrico, quando vinculado a uma pessoa natural;

[…]

Art. 7º O tratamento de dados pessoais somente poderá ser realizado nas seguintes hipóteses:

[…]

VIII – para a tutela da saúde, exclusivamente, em procedimento realizado por profissionais de saúde, serviços de saúde ou autoridade sanitária;

[…]

Art. 11. O tratamento de dados pessoais sensíveis somente poderá ocorrer nas seguintes hipóteses:

[…]

f) tutela da saúde, exclusivamente, em procedimento realizado por profissionais de saúde, serviços de saúde ou autoridade sanitária;

[…]

§ 4º É vedada a comunicação ou o uso compartilhado entre controladores de dados pessoais sensíveis referentes à saúde com objetivo de obter vantagem econômica, exceto nas hipóteses relativas a prestação de serviços de saúde, de assistência farmacêutica e de assistência à saúde, desde que observado o § 5º deste artigo, incluídos os serviços auxiliares de diagnose e terapia, em benefício dos interesses dos titulares de dados […]

§ 5º É vedado às operadoras de planos privados de assistência à saúde o tratamento de dados de saúde para a prática de seleção de riscos na contratação de qualquer modalidade, assim como na contratação e exclusão de beneficiários (BRASIL, 2018).

Na área da Saúde, os dados têm origem em fontes diversas: pessoais, clínicos, de procedimentos e de exames. De acordo com a Lei nº 13.787, de 27 de dezembro de 2018, os prontuários eletrônicos devem ser guardados por um prazo mínimo de 20 anos. O Marco Civil da Internet (Lei nº 12.965, de 23 de abril de 2014) também trata do tema do tema em seu artigo 11°:

Art. 11. Em qualquer operação de coleta, armazenamento, guarda e tratamento de registros, de dados pessoais ou de comunicações por provedores de conexão e de aplicações de internet em que pelo menos um desses atos ocorra em território nacional, deverão ser obrigatoriamente respeitados a legislação brasileira e os direitos à privacidade, à proteção dos dados pessoais e ao sigilo das comunicações privadas e dos registros (BRASIL, 2014).

A LGPD prevê a possibilidade de eliminação dos dados pessoais quando houver solicitação por parte de seu titular, contudo, devido à importância de seu uso em pesquisas, os dados de Saúde podem vir a ser considerados como um “bem público global”.

O acesso a dados em Saúde pode prever uma possível epidemia. No caso da Saúde Coletiva, o monitoramento de informações sociais e clínicas tem o potencial de auxiliar na previsão do maior impacto de uma epidemia, atuando no aprimoramento das políticas públicas. Entretanto, o direito à Saúde e à privacidade devem caminhar juntos, sem um canibalizar o outro.

Por tal motivo, a segurança e a governança dos dados são fundamentais. Os sistemas público e privado devem ter regras claras de quais dados podem e devem ser coletados, onde serão armazenados, quem pode acessá-los e para que serão utilizados. A partir disso, o acesso aos dados deve ser controlado de acordo com perfis específicos. É preciso dar atenção a medidas de segurança como criptografia para evitar vazamento dos dados como o ocorrido com o Hospital do Barreiro (Portugal):

O Hospital do Barreiro tem 296 médicos colocados, mas os sistemas internos permitiam que mais de 900 médicos continuassem com as contas de acesso a repositórios clínicos ativas. Contas de assistentes sociais, falhas no sistema de autenticação e a inexistência de regras de acesso também contribuíram para a aplicação de coimas ao abrigo do novo Regulamento Geral de Proteção de Dados (SÉNECA, 2018).

Caso similar ocorreu nos Países Baixos. O “Haga Hospital” foi multado em 460 mil euros por violar a GDPR (General Data Protection Regulation), lei europeia análoga à LGPD. O hospital possuía regras frágeis para o controle de acesso a dados de pacientes.

Além das informações clínicas, os dados genômicos também podem ser utilizados para prever a possibilidade de aparecimento de enfermidades. A “medicina preditiva” atua no diagnóstico de doenças hereditárias com base na análise de informações genéticas. A aposta da genômica clínica é promover tratamentos personalizados com o uso de medicamentos mais eficazes.

O acesso a dados do genoma humano ainda não é tão comum na medicina, contudo, com a crescente popularização de testes de ancestralidade, os próprios usuários geram dados genômicos pessoais que podem ser utilizados para outros fins até mesmo com autorização do titular a fim de supostamente tentar encontrar sua árvore genealógica.

Neste sentido, são os próprios usuários que autorizam o compartilhamento de suas informações pessoais de Saúde. O mesmo acontece com aplicativos ligados à qualidade de vida como Strava, Google Health, Garmin Connect, entre outros. Por meio de uma dinâmica, “gamificada”, os usuários destas ferramentas são engajados no compartilhamento cada vez maior de suas atividades cotidianas (esportes, sono e jornada de trabalho).

Por outro lado, mesmo com vedação legal, é preciso estar atento à tentativa de precificar planos de saúde suplementar a partir da probabilidade de uso futuro dos serviços médicos com base em informações pessoais. Conforme visto anteriormente, a Internet das Coisas Médicas (IoMT) possibilitará o monitoramento da Saúde em tempo real por meio de dispositivos conectados, tais quais os vestíveis (wearable devices). Pela lógica, uma pessoa desconfiaria se o plano de saúde tentasse acessar as informações dos wearable devices. Porém, situação similar ocorreu com a parceria entre farmácias e planos de saúde suplementar, que oferecem benefícios aos clientes em troca dos dados pessoais.

O acesso desregulado a dados como estes poderia ainda criar um cenário de interferência na contração de funcionários, pois os recrutadores saberiam antecipadamente se uma pessoa está grávida ou se sofre de algum transtorno mental como depressão, bipolaridade ou pânico. Esta possibilidade é acentuada em populares sistemas de recrutamento online que utilizam inteligência artificial para a análise dos dados dos candidatos, como o Gupy que dispõe da IA Gaia.

Em 2023, a Sulamérica criou um sistema que chamou de “cashback” em parceria com o aplicativo de exercícios físicos Gympass. O usuário que comprovar ter feito atividades físicas (pelo menos duas vezes por semana durante seis meses) recebe, pela operadora, o reembolso do valor gasto com o aplicativo Gympass.

Em princípio, a “promoção” atuaria dentro da tentativa de mudança de cultura médica, migrando do “sickcare” para o “healthcare”, todavia possui potencial para acesso a dados pessoais de bem estar, deixando vulneráveis os usuários de planos de saúde suplementar na medida em que suas informações pessoais podem ser levadas em conta no momento de reajuste, definição da carência ou da negativa de determinada cobertura.

REFERÊNCIAS:

BRASIL. Lei n º 12.965, de 23 de abril de 2014. Estabelece princípios, garantias, direitos e deveres para o uso da Internet no Brasil. Diário Oficial da União, Brasília, DF, 2014. Disponível em: http://www.planalto.gov.br/ccivil_03/_ato2011-2014/2014/lei/l12965.htm. Acesso em: 25 abr. 2023.

BRASIL. Lei nº 13.709, de 14 de agosto de 2018. Lei Geral de Proteção de Dados Pessoais (LGPD). Diário Oficial da União, Brasília, DF, 2018. Disponível em: https://www.planalto.gov.br/ccivil_03/_ato2015-2018/2018/lei/l13709.htm. Acesso em: 25 abr. 2023.

BRASIL. Lei nº 13.787, de 27 de dezembro de 2018. Dispõe sobre a digitalização e a utilização de sistemas informatizados para a guarda, o armazenamento e o manuseio de prontuário de paciente. Diário Oficial da União, Brasília, DF, 2018. Disponível em: https://www.planalto.gov.br/ccivil_03/_ato2015-2018/2018/lei/l13787.htm. Acesso em: 25 abr. 2023.

DARIN, B. CVS Health Paves Path to Better Care With Data, AI – WSJ. Disponível em: https://deloitte.wsj.com/articles/cvs-health-paves-path-to-better-care-with-data-ai-01615406532. Acesso em: 25 abr. 2023.

SANTOS, A. W. C.. Inteligência Artificial Generativa, dados pessoais e Literacia Digital em Saúde: possibilidades, desigualdades e limites. Disponível em: https://arthurwilliam.com.br/wp-content/uploads/2023/05/Inteligencia-Artificial-Generativa-dados-pessoais-e-Literacia-Digital-em-Saude-Arthur-William-Cardoso-Santos.pdf. Acesso em: 31 mai. 2023.

SÉNECA, H. Visão | CNPD: Hospital do Barreiro multado em 400 mil euros por permitir acessos indevidos a processos clínicos. Disponível em: https://visao.sapo.pt/exameinformatica/noticias-ei/mercados/2018-10-19-cnpd-hospital-do-barreiro-multado-em-400-mil-euros-por-permitir-acessos-indevidos-a-processos-clinicos/. Acesso em: 23 abr. 2023.

SOARES, L. Google volta a tentar coletar dados de saúde dos usuários. Olhar Digital, 12 abr. 2021. Disponível em: https://olhardigital.com.br/2021/04/12/medicina-e-saude/google-volta-a-tentar-coletar-dados-de-saude-dos-usuarios/. Acesso em: 25 abr. 2023.

por Arthur William Cardoso Santos | jun 6, 2023 | convergência, Inteligência Artificial

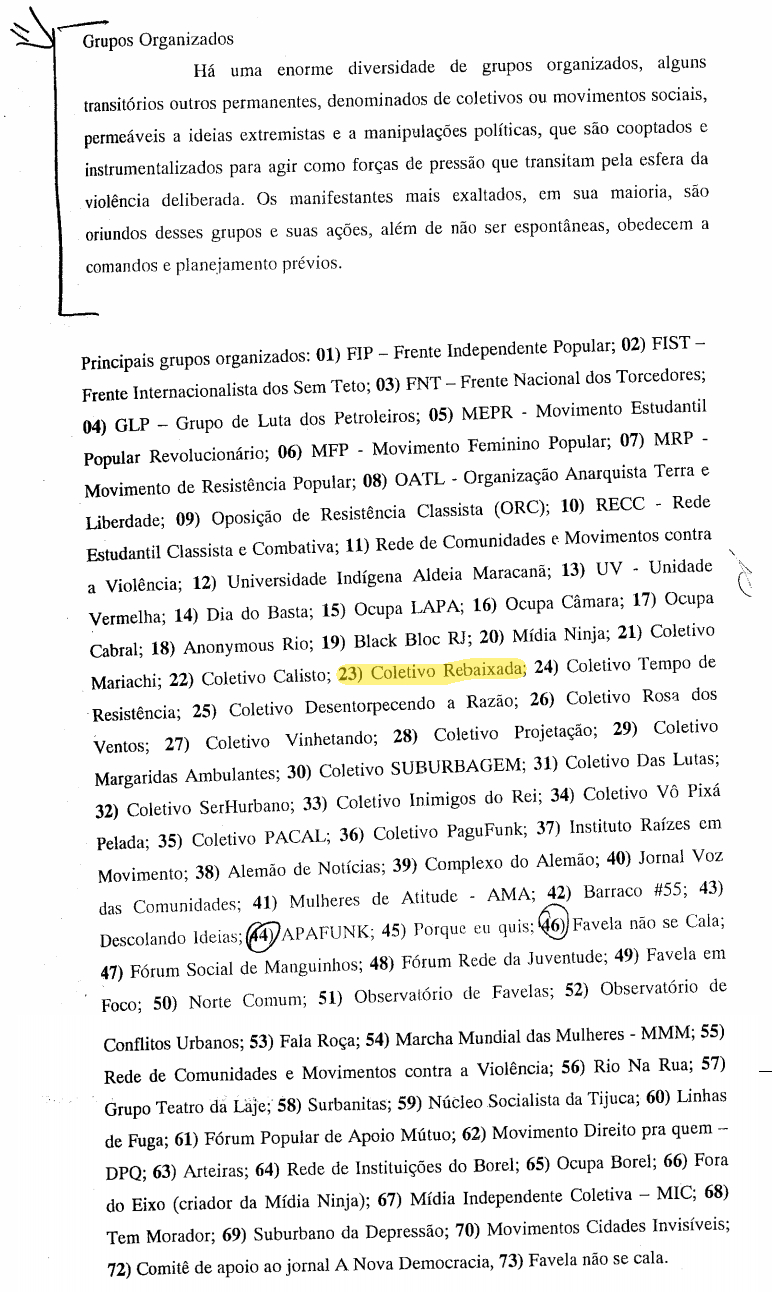

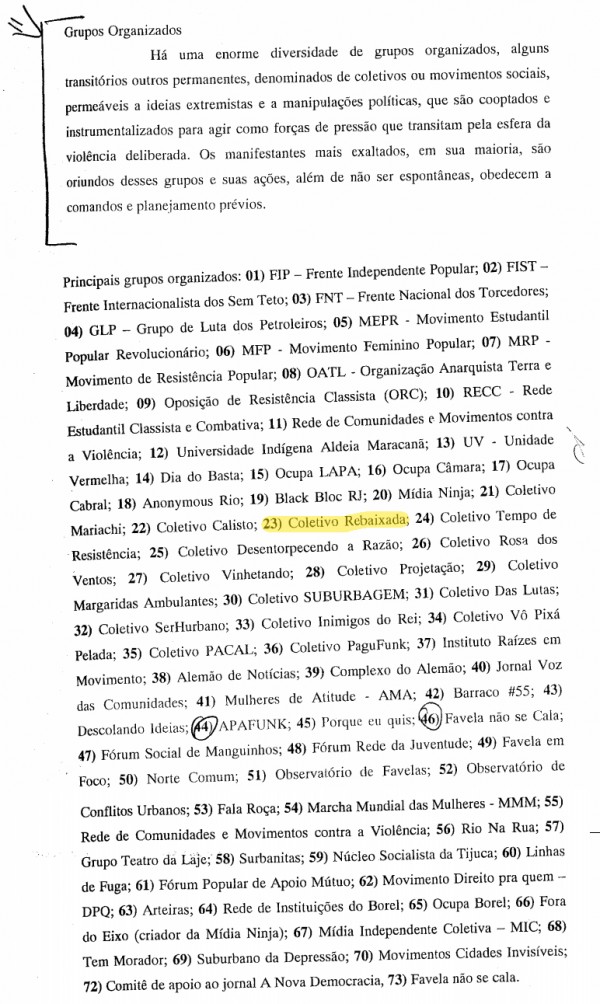

Robô foi incluído no inquérito policial que investigou as “Jornadas de Junho de 2013” (manifestações entre Junho de 2013 e Julho de 2014)

Em minha pesquisa de mestrado, criei um robô que fazia o “web scraping” das publicações sobre as manifestações entre 2013 e 2014 com o objetivo de analisar os dados de forma similiar a outros trabalhos científicos no período. Mesmo o site explicando o projeto, surpresa minha foi ver o robô confundido com um grupo de pessoas reais pelo relatório da Operação Firewall que investigou as manifestações entre junho de 2013 até a final da Copa do Mundo de 2014.

Aquela confusão, há 10 anos atrás, deixou claro o potencial de desinformação que uma mídia sintética poderia gerar na sociedade, situação agravada hoje em dia com o desenvolvimento da inteligência artificial generativa. O robô que criei não era tão sofisticado quanto os softwares na linguagem R que os professores Fabio Malini (Labic-UFES) e Raquel Recuero (UCPel) utilizavam para produzir seus grafos nas pesquisas de ciência de dados sobre os protestos de 2013/2014. No meu caso, os plug-ins do WordPress faziam a raspagem dos dados das redes sociais e copiavam as informações para um site, que era indexado pelo Google, diferentemente das redes sociais fechadas como o Facebook. Além disso, o robô traduzia automaticamente todos os textos para três línguas (inglês, espanhol e francês) via API do Google Tradutor e divulgava os links de forma automatizada pelo Twitter. Quando saiu o relatório da investigação policial, acabei desativando o robô “Rebaixada” que havia sido desenvolvido durante oficinas na própria universidade. O relato completo desta história está descrito na minha dissertação de mestrado pela UERJ – Universidade do Estado do Rio de Janeiro.

REFERÊNCIAS:

SANTOS, A. W. C.. Pesquisa de mestrado no inquérito da Polícia. Disponível em: https://arthurwilliam.com.br/blog/pesquisa-de-mestrado-no-inquerito-da-policia/. Acesso em: 1 ago. 2014.

SANTOS, Arthur William Cardoso. Rebaixada: hub da multidão inteligente durante os megaeventos. 2015. 108 f. Dissertação (Mestrado em Educação, Cultura e Comunicação) – Faculdade de Educação da Baixada Fluminense, Universidade do Estado do Rio de Janeiro, Duque de Caxias, 2015. Acesso em: 7 out. 2015.

LINKS:

Rebaixada.org (Web Archive – Wayback Machine)

Rebaixada.com.br (Web Archive – Wayback Machine)

Twitter do Robô Rebaixada em Português

Twitter do Robô Rebaixada em Inglês

Twitter do Robô Rebaixada em Espanhol

Twitter do Robô Rebaixada em Francês

por Arthur William Cardoso Santos | jun 5, 2023 | Inteligência Artificial, Saúde

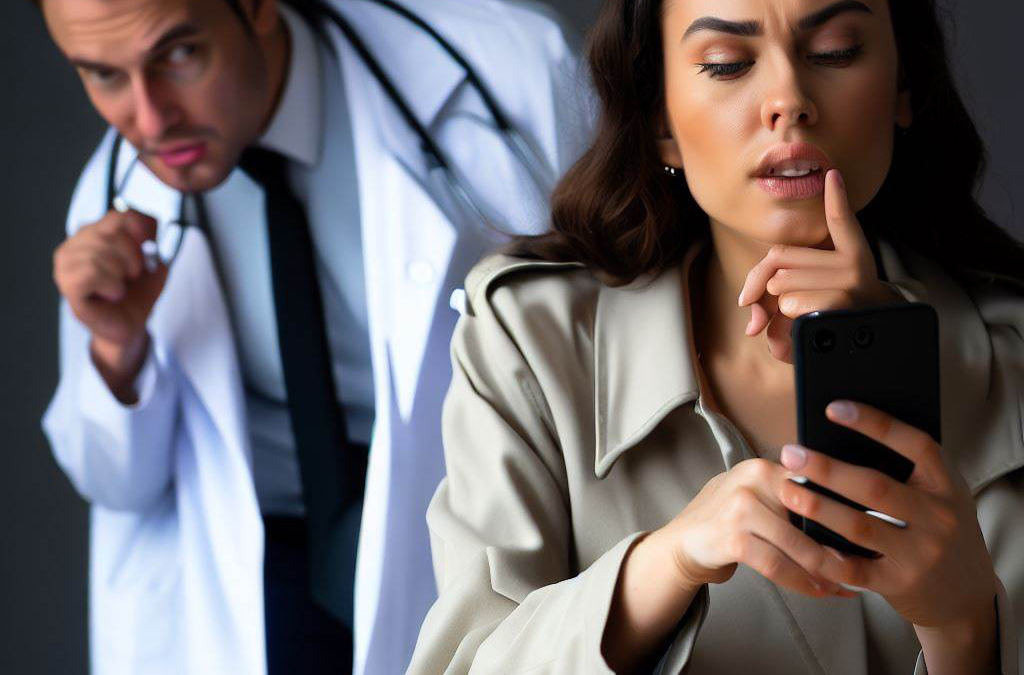

Adivinhe qual das imagens sintéticas acima foi criada pela Inteligência Artificial a partir do prompt genérico “Médica com tablet na mão e códigos binários a sua volta”? A imagem da direita teve que ser editada com a descrição específica “Médica negra”.

Além da desigualdade no acesso a recursos de Inteligência Artificial, a iniquidade de serviços de “machine learning” pode acarretar em respostas equivocadas por parte das ferramentas de Inteligência Artificial. Como as primeiras aplicações foram desenvolvidas com dados de populações de países desenvolvidos, a máquina pode reproduzir preconceitos com populações distintas, processo chamado de Bias ou viés. A análise automatizada de exames de imagem agiliza a confecção de laudos e pode prever o aparecimento de doenças, porém, para ser efetiva e não resultar em erros, precisa levar em conta dados que muitas vezes não estão presentes.

Neste sentido, se não houver políticas públicas para a inclusão de populações vulnerabilizadas em ações de “machine learning”, especificidades étnicas podem ser desconsideradas pelos sistemas de IA, prejudicando a análise de dados de indígenas brasileiros, por exemplo. Isto porque, se estiver apenas pautada pelo potencial econômico da coleta de dados, informações de segmentos sociais historicamente excluídos podem não ser levadas em conta pela IA. A partir de 2023, o DataSUS anunciou que vai obrigar o preenchimento de informações como raça e cor.

Outro ponto de atenção diz respeito à consideração da variável étnica nos indicadores clínicos como a oxigenação do sangue, por exemplo. Como o oxímetro tem sua medição afetada pela cor de pele do paciente, um sistema de IA que desconsidere este fator pode ocorrer em grave equívoco com potencial para até mesmo causar a morte de um paciente.

A Inteligência Artificial Generativa também esbarra no tema do preconceito. Isto porque as LLMs utilizam grande modelos de linguagem que se alimentam de datasets compostos por conteúdos disponíveis na internet: textos e imagens que podem conter viés preconceituoso. A resposta de um chatbot como o ChatGPT é um processamento de variadas fontes opacas. A ausência de “explicabilidade” das fontes das informações dificulta a identificação de vieses (biases).

Esta situação é de mais fácil percepção nas aplicações de imagens como Midjourney, Bing Image Creator, Adobe Firefly e o DALL-E. Ao imputar um prompt solicitando a criação de uma imagem de um médico ou de um empresário de sucesso, a probabilidade de o material gerado conter uma mulher negra é muito menor, pois os sistemas foram treinados com material que reproduz este estereótipo.

Em “machine learning”, a máquina aprende a identificar padrões e este aprendizado pode ser “supervisionado” ou “não supervisionado”. No aprendizado supervisionado, o treinamento da Inteligência Artificial é realizado a partir de material previamente rotulado. No caso da imagem da médica, um ser humano faria uma análise prévia do que considera ser a representação de médicos, análise subjetiva que pode ser influenciada por estereótipos.

Já no aprendizado “não supervisionado”, a máquina tenta identificar padrões com base nos dados imputados, ou seja, se foi treinado com a quase totalidade das imagens de profissionais de Saúde com a pele branca, consequentemente concluirá um determinado “padrão” de cor de pele para médicos.

O GPT passou por um processo de RLHF (Reinforcement Learning from Human Feedback, aprendizagem por reforço por resposta humana), em que pessoas reais diziam se as criações da IA estavam certas ou erradas, durante a fase de testes. Além disso, a Inteligência Artificial reproduz ainda a visão de mundo de seus programadores, em geral, homens brancos residentes nos Estados Unidos.

O GPT-3 foi treinado a partir de cinco conjuntos de dados: Common Crawl, WebText2, Wikipedia, Books1 e Books2. Os três primeiros conjuntos de fontes são compostos por conteúdos variados da internet. Já o GPT-4 já possui uma preocupação maior com textos preconceituosos, porém esta versão encontra-se apenas acessível a usuários PLUS do ChatGPT ao custo de 20 dólares mensais.

REFERÊNCIAS:

EVANGELISTA, A. P. Sistemas do SUS não têm dados suficientes de raça/cor da pele de pacientes durante a pandemia. Disponível em: https://www.epsjv.fiocruz.br/podcast/sistemas-do-sus-nao-tem-dados-suficientes-de-racacor-da-pele-de-pacientes-durante-a-pandemia. Acesso em: 25 abr. 2023.

LIMA, J. DA C. Desafios para a adoção de Inteligência Artificial pelo Sistema Único de Saúde (SUS): ética, transparência e interpretabilidade. Tese (Doutorado em Informação e Comunicação em Saúde) – Instituto de Comunicação e Informação Científica e Tecnológica em Saúde, Fundação Oswaldo Cruz, Rio de Janeiro, 2022.

NUNES, D.; MORATO, O. A explicabilidade da inteligência artificial e o devido processo tecnológico. Disponível em: https://www.conjur.com.br/2021-jul-07/opiniao-explicabilidade-ia-devido-processo-tecnologico. Acesso em: 25 abr. 2023.

SANTOS, A. W. C.. Inteligência Artificial Generativa, dados pessoais e Literacia Digital em Saúde: possibilidades, desigualdades e limites. Disponível em: https://arthurwilliam.com.br/wp-content/uploads/2023/05/Inteligencia-Artificial-Generativa-dados-pessoais-e-Literacia-Digital-em-Saude-Arthur-William-Cardoso-Santos.pdf. Acesso em: 31 mai. 2023.

Página 2 de 22«12345...1020...»Última »